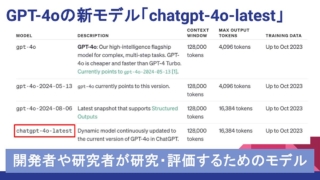

GPT-4o新モデルが8/6発表!料金値下げ、出力上限16kなどアップデート内容解説

2024年8月6日にOpenAIはGPT-4oの新しいモデル「GPT-4o-2024-08-06」を発表しました。

JSONなどスキーマなどの構造化データ対応モデルで、確実に構造化データで出力が可能となりました。

さらに最大出力トークン数も16kに上限緩和され、元々のモデルよりもAPI利用料金が値下げされています。

8月6日登場のGPT-4o新モデルのアップデートされたポイントを解説します。

2024年8月6日にGPT-4oに新しいモデルが発表

2024年8月6日(アメリカ時間)にOpenAIはGPT-4oの新しいモデルを発表しました。

Introducing Structured Outputs in the API(OpenAI)

主にDeveloper、開発者向けの発表内容として、APIに構造化出力を導入したことを紹介しています。

これによって非構造化データからJSONスキーマで定義された構造化データに確実に準拠できるようになったとのことです。

ただ、GPT-4oの新しいモデルには構造化出力だけでなく他にも大きなアップデートがありました。

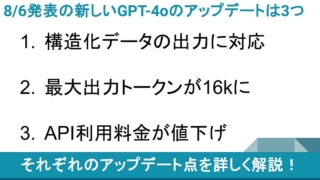

新しいGPT-4oの大きなアップデートは3つ

2024年8月6日に新しく登場したGPT-4oになってアップデートしたポイントは大きく以下の3つです。

- 構造化データの出力に対応

- 最大出力トークンが16kに

- API利用料が値下げ

今回の大きなアップデートポイントである紹介した3つについて詳しく解説していきます。

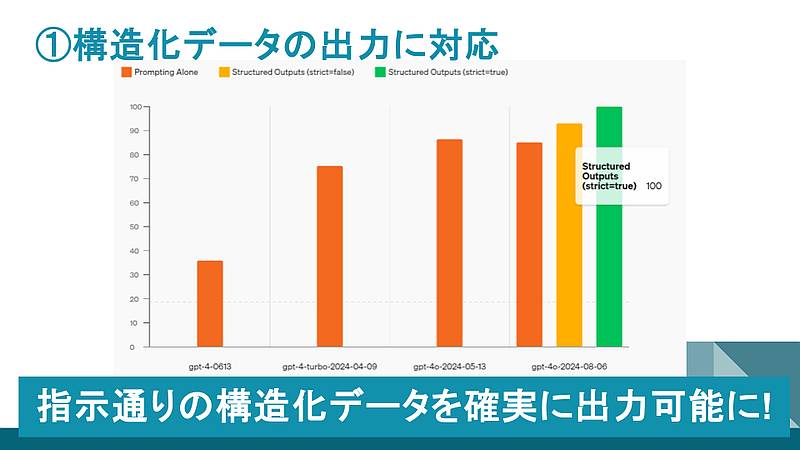

①構造化データの出力に対応

2024年8月6日に発表されたGPT-4oの新しいモデル(gpt-4o-2004-08-06)では、JSONスキーマの構造化データに確実に準拠するようになりました。

従来モデルのGPT-4oだとプロンプトにJSONスキーマを入力し、スキーマに従った構造化データの出力を要求しても、その通りのアウトプットが得られませんでした。

そのために強い命令口調で指示を出すなどのプロンプトエンジニアリングも研究されましたが、確率は高まっても100%を実現できませんでした。

OpenAIは新しく改良したGPT-4oのモデルでは、strictというパラメータを「true」にすることで、定義したJSONスキーマに従った構造化データが出力されるようになりました。

OpenAIが構造化出力の検証テストした結果、従来のGPT-4では40%しか満たせなかったのに対し、新しいGPT-4oはstrictパラメータを有効にすることで100%実現できたと発表しています。

従来のGPT-4oでも正しく構造化データが出力できたのは86%程度だったため、うまく生成できないケース処理が必要です。

新たなGPT-4oのモデルによって、生成AIを非構造化データをリクエストして構造化データに変換するAPIとして利用できるようになりました。

今回のアップデートでJSONスキーマで定義した構造化データが確実にアウトプットされるのはとても大きいです。

②最大出力トークンが16kに上限拡張

従来のGPT-4oのモデルでは入力プロンプトに対する、出力結果の最大トークン数は4096トークンでした。

一方、8月6日に発表された新モデルは「gpt-4o-2024-08-06」と書かれたモデルです。

出力トークン数の上限が4倍の16kトークンまで拡張されました。

出力上限が16kトークンというのはGPT-4o miniと出力トークン数の上限が同じになります。

GPT-4oを使って行数が膨大な大規模なシステムのコード生成を行う場合、大容量の出力が必要です。

しかし、これまでは4096トークンが上限だったため、細切れで受け取り、続きを要求して繋ぎ合わせなければなりませんでした。

今回のアップデートで大規模なコードの出力なども1回で出せるようになりました。

ただ、現時点で試した人の感想によると、最大トークン数のパラメータを16kトークンに設定しても、まだ出力結果は小さく出されるケースも多いようです。

③API利用料が入力50%OFF、出力33.3%OFFと安く

新しいGPT-4oのモデルの3つ目の大きなアップデートはAPI利用料金です。

トークンあたりのAPI従量料金が値下げされています。

従来は入力100万トークンに対し5ドル、出力100万トークンに対して15ドルでした。

今回のアップデートによって、入力100万トークンに対し2.5ドル、出力100万トークンに対して10ドルになりました。

入力は50%OFFと半額になり、出力も33%OFFまで値下げになっています。

GPT-4oのAPI利用料金が安くなったことで、汎用AIモデルのGPT-4o miniと上位AIモデルのGPT-4oが使い分けしやすくなりました。

マルチモーダル画像入力も安く

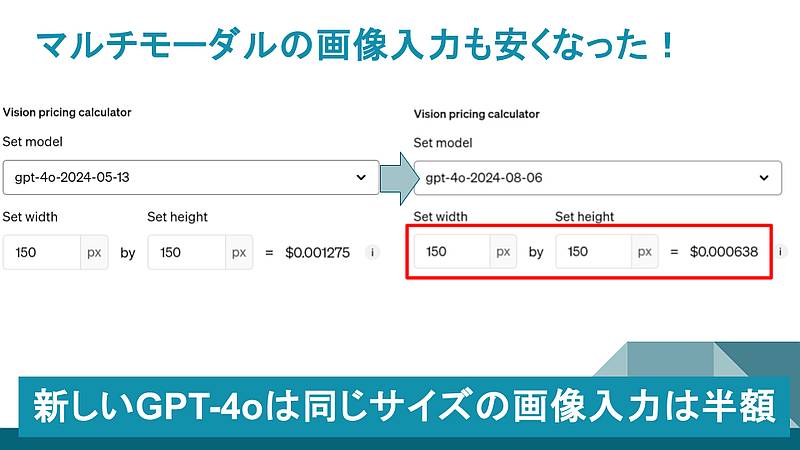

GPT-4oの新しいモデルでAPI利用料金が安くなったのはテキストプロンプトだけではありません。

マルチモーダル入力の画像入力についても料金が安くなりました。

デフォルト記載されている150px、150pxの画像の場合、従来のGPT-4oよりも半額になっています。

これによってマルチモーダル入力も利用しやすくなりました。

画像入力についてはGPT-4o miniよりも安い

新しいモデルのGPT-4oがマルチモーダル画像入力のAPI利用料金を値下げしたことで驚きの事象が発生しました。

なんとGPT-4o miniの画像入力の料金よりもGPT-4oの方が安くなっています。

OpenAIのAPI価格ページで確認すると、GPT-4o miniのAPIにおける画像入力の利用料金はGPT-4oと同額でした。

しかし、新しいGPT-4oのモデルは従来モデルの半額になったことで、GPT-4o miniの方が利用料金が高いという逆転減少が起きています。

もちろんテキスト入力はGPT-4o miniの方が安いですが、マルチモーダルな画像入力を利用する頻度が高いAPIユースケースではGPT-4oに切り替えた方が性能的だけでなく、料金的にも良いケースが起こり得ます。

学習データは従来のモデルと同じ2023年10月まで

なお、学習データ(訓練データ)は従来モデルと同じです。

2023年10月までの学習データを利用しています。

そのため、2024年の新しい学習データは未反映なため、直近の出来事や情報は答えることができません。

新しいGPT-4oのモデル利用時の注意点

新しいGPT-4oのモデルをAPIで利用する際の注意点をお伝えします。

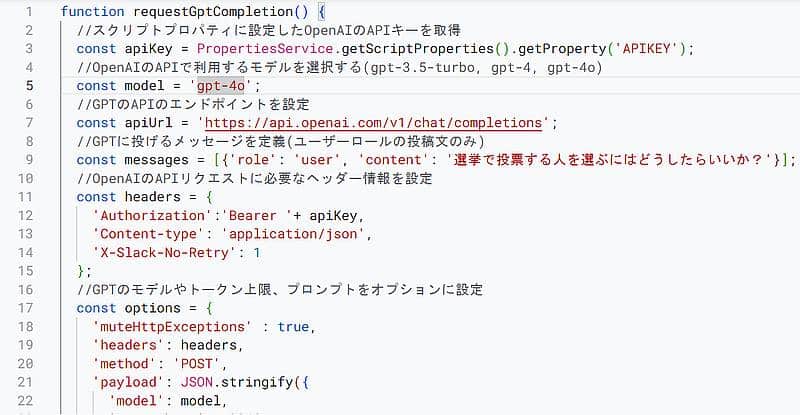

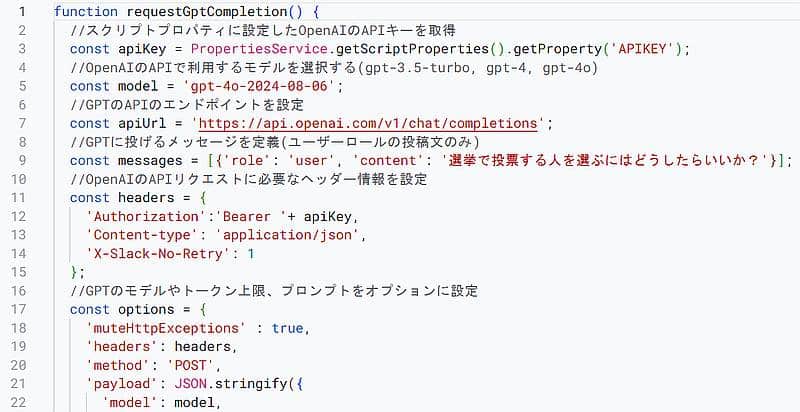

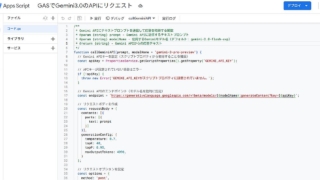

注意すべきはAPI経由でGPT-4oを利用する場合に、modelパラメータで「gpt-4o」と指定してはいけないことです。

現在、「gpt-4o」とAPIのモデルパラメータに設定すると、2024年8月6日以前のモデルが使用されます。

新しいモデルではなく従来モデルとして処理されるため、アップデートされた構造化データ対応や16kの出力トークン上限、値下げされたAPI利用料は適用されません。

従来のGPT-4oを利用する場合、Google Apps Scriptではモデル指定をgpt-4oとしていました。

新しいモデルを指定したい場合にはmodelパラメータに「gpt-4o-2004-08-06」と指定します。

明示的に新モデル名を指定することで、きちんと新しいモデルとして実行されます。

gpt-4oが新しいモデルに切り替わるには3週間程度かかるため、それまでは日付の入ったモデル名を指定しましょう。

※9月以降であれば、gpt-4oでの指定でも問題ありません。

まとめ・終わりに

今回、2024年8月6日に発表されたGPT-4oの新しいモデルのアップデートポイント3つと注意点を紹介しました。

GPT-4oの新しいモデルはユーザー側が指示したJSONスキーマを確実に準拠して、求める構造化データを出力できるようになりました。

さらにアウトプットの最大トークン数が16kに拡張されて、従来の4倍まで出力可能です。

その上、GPT-4oのAPI利用料金も入力が50%OFF、出力が33%OFFと安くなりました。

OpenAIの上位AIモデルだったGPT-4oがさらに使いやすくなりました。

構造化データが確実に出力されるようになったので、非構造化データを変換するAPIとしてぜひ活用しましょう。

なお、現時点ではGPT-4o-2024-08-06と日付入りのモデル名を指定する必要があるので注意してください。

ディスカッション

コメント一覧

まだ、コメントがありません